亲爱的读者们,

在这个数字化时代,我们每天都在与海量数据打交道,无论是社交媒体的用户行为分析,还是电子商务的销售预测,"通用Spark"这个名字已经成为了数据处理领域的明星,我们就来一起深入探讨这个强大的工具,让你的业务数据焕发新的活力。

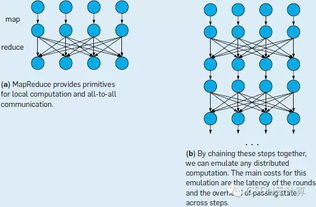

让我们理解什么是Spark,Spark,全称Apache Spark,是一款由Apache基金会维护的开源分布式计算框架,它在大数据处理领域具有无可替代的地位,与Hadoop MapReduce相比,Spark的速度快了近100倍,这得益于其内存计算的特性,使得数据处理不再受限于磁盘I/O,大大提升了计算效率。

内存计算:速度翻倍的秘密

Spark的核心优势在于它的内存计算模型,也被称为"弹性分布式数据集"(Resilient Distributed Datasets,简称RDD),与Hadoop的磁盘计算方式不同,Spark将数据加载到内存中,进行快速迭代运算,这就像做作业时,直接把答案存在脑子里,而非反复查书一样高效,据统计,Spark的内存利用率可以高达90%,这意味着在处理大量数据时,我们能获取更高的计算速度。

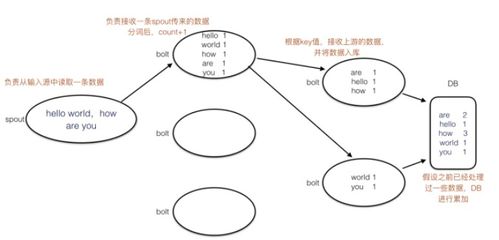

批处理与流处理:满足多样化需求

Spark不仅仅局限于批处理,它还支持实时流处理,如Apache Flink和Kafka Connect,对于新闻网站,实时监控热点话题的浏览量,或者银行系统对交易流的实时分析,Spark流处理都能提供强大的支持,这种灵活性使得企业可以根据业务需求,选择最合适的处理模式。

Spark SQL和MLlib:数据分析与机器学习

Spark SQL提供了一种简洁的SQL接口,让你像操作关系型数据库一样处理大规模数据,而对于机器学习任务,Spark的MLlib库内置了丰富的算法,如分类、回归、聚类等,无需额外学习,即可快速构建模型,Netflix就利用Spark进行用户推荐系统的优化,显著提升了用户体验。

案例分享:阿里巴巴的实战经验

阿里巴巴作为全球领先的电商巨头,也是Spark的重度使用者,他们曾在2015年的一次交易系统升级中,使用Spark实现了数据处理速度的提升400%,成功应对了双十一购物狂欢的海量数据压力,这个例子无疑展示了Spark在实际场景中的强大能力。

拥抱通用Spark,开启数据新篇章

随着大数据时代的到来,提升数据处理效率成为了企业竞争力的关键,Spark以其独特的内存计算、多元化的处理能力以及强大的社区支持,无疑是你实现这一目标的理想选择,不要犹豫,现在就开始你的Spark之旅吧,让数据的力量推动你的业务创新!

如果你对Spark还有更多的疑问,或者想要深入了解如何在你的项目中应用,欢迎在评论区留言,我们将为你提供更详尽的解答,让我们一起探索Spark的无限可能,共同引领数据驱动的未来!